La llegada de los deepfakes

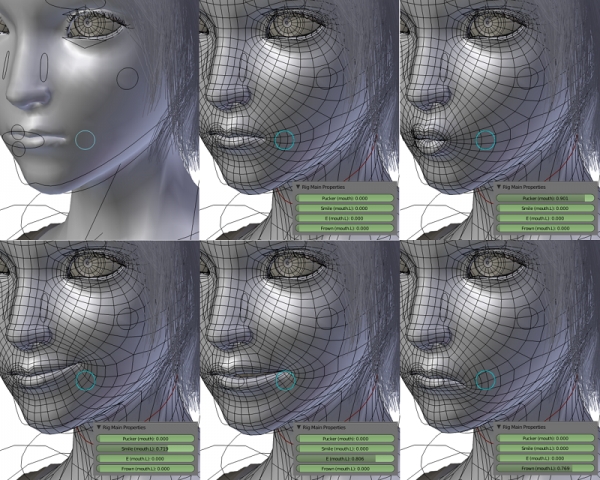

Un deepfake es un contenido audiovisual alterado mediante inteligencia artificial (deep learning). Lo más popular es cambiar la expresión facial de alguien. Otras veces se mezclan los rasgos de dos personas.

Los primeros aparecieron en 2019, aunque su auge llegó durante la pandemia de covid-19.

En 2021, una cuenta de TikTok publicó varios vídeos de Tom Cruise. ¿Dónde ha aprendido Tom Cruise a hacer magia? ¿Desde cuándo sabe tocar la guitarra? En realidad, eran grabaciones hechas a un doble del actor. Los vídeos, que representaron un salto de calidad en este tipo de producciones, se editaron con programas informáticos y algoritmos de inteligencia artificial.

En campaña electoral

En 2024, tras analizar la presencia de deepfakes en procesos electorales, un estudio concluyó que muchos de ellos son difundidos por el entorno político.

El objetivo puede ser promocionar una campaña. O desacreditar al rival. Esta tendencia ha llegado recientemente a España.

Algunos vídeos han sido eliminados ante las protestas, ya que, además, pueden perjudicar la imagen pública de terceros.

La polémica surge también al justificar su uso. ¿Este tipo de tecnologías permite que la comunicación “evolucione”? ¿Las campañas de publicidad con deepfakes son “más eficaces”?

¿Afectan a la confianza en los medios de comunicación?

Un estudio publicado en 2025 aborda esta cuestión, centrándose en el impacto de los deepfakes en la credibilidad de los medios. Según los autores, esta práctica provoca una pérdida de confianza en el medio de comunicación, tal y como constataron los participantes tras ser informados del engaño.

Por otro lado, apunta que no está claro si estar expuestos a estos contenidos afecta a nuestra capacidad para diferenciar entre una imagen real y una falsa. Asimismo, los autores no pudieron encontrar qué factores hacen a un formato deepfake más o menos creíble. De hecho, no parece que estos vídeos decepcionen más a la audiencia que una noticia falsa escrita al modo tradicional.

Arma contra la desinformación

La comunidad científica propone usar la inteligencia artificial para luchar contra la desinformación.

El procesamiento del lenguaje natural, que estudia las expresiones que aparecen en los textos, es eficaz para detectar inconsistencias en noticias falsas.

Además, el aprendizaje automático, que analiza grandes volúmenes de texto para hacer predicciones, puede ayudar a discernir entre informaciones reales y falsedades.

Otra herramienta es el análisis de sentimientos, que evalúa el tono o emoción de un texto y es útil para buscar contenido polarizado en redes sociales.

Ventajas y desventajas

Estas técnicas tienen ventajas frente a los moderadores de contenido humanos. La primera es que la inteligencia artificial analiza mucha más información. Además, lo hace de forma automática en mucho menos tiempo.

Otra ventaja es la inmediatez: podemos detectar en tiempo real tendencias y temáticas que surgen en redes sociales. Esto ayuda a intervenir más rápido.

Sin embargo, las herramientas de IA también tienen limitaciones. Carecen de contexto para entender expresiones de lenguaje complejas. No saben interpretar dobles sentidos.

Un inconveniente más es que están sesgadas por la información verídica y falsa con la que han sido entrenadas. Además, no son transparentes en sus decisiones a la hora de determinar si una noticia es falsa o no.

Entonces, ¿es posible detectar deepfakes?

La regulación europea exige identificar un contenido audiovisual generado por inteligencia artificial. Estas normativas pueden persuadir a personalidades públicas, medios de comunicación o empresas, cuando lo que está en juego es preservar su reputación.

Por otra parte, la misma tecnología que genera los deepfakes puede ayudar a detectarlos. Tras procesar grandes cantidades de ejemplos, la IA aprende a encontrar características que distingan contenidos falsos y reales.

A día de hoy, no obstante, la generación de deepfakes está mucho más avanzada que la detección. Si la calidad de la imagen es baja, los detectores tienen problemas para poder analizarla. A esto se suma que aún arrojan bastantes “falsos positivos”, es decir, catalogan muchas veces como deepfake un contenido que no lo es.

Mientras tanto, lo que está claro es que la generación de contenido con inteligencia artificial va a continuar en aumento. La precisión de las caras, los movimientos humanos y las voces seguirá perfeccionándose.

Pero la batalla no está ahí. La clave está en hacer un uso responsable y ético de la inteligencia artificial.